开源的deepseek可以在本地部署;

- 安装Ollama, https://ollama.com/ 进入官网选择下载:

linux:

curl -fsSL https://ollama.com/install.sh | sh

Windows:

https://github.com/ollama/ollama/releases/download/v0.5.7/OllamaSetup.exe

mac:

https://github.com/ollama/ollama/releases/latest/download/Ollama-darwin.zip

在自己Windows机器上面安装,运行OllamaSetup.exe默认安装在C盘磁盘空间要足够大一点。

- 选择deepseek模型,搜索点击 Deepseek-r1 会有多个参数模型选择,根据自己主机性能选择:

参数规模(B 是 Billion首字母,十亿的意思)代表模型的复杂度和学习能力,参数越大,模型能处理的任务越复杂。

这里有几个选项:

1.5B:对于硬件配置较低的电脑(比如4GB内存和核显的配置)很合适。

7B-14B:大部分电脑都能运行这个版本,性能也平衡,个人使用,低并发,本地测试,基础任务(文本生成,简单问答)。

32B - 70B:中等规模,平衡性能与资源消耗,适合复杂任务(逻辑推理、代码生成)。

671B:超大规模,专为高性能场景设计(如科研、复杂问题解决),可能采用MoE架构(混合专家模型)优化效率。

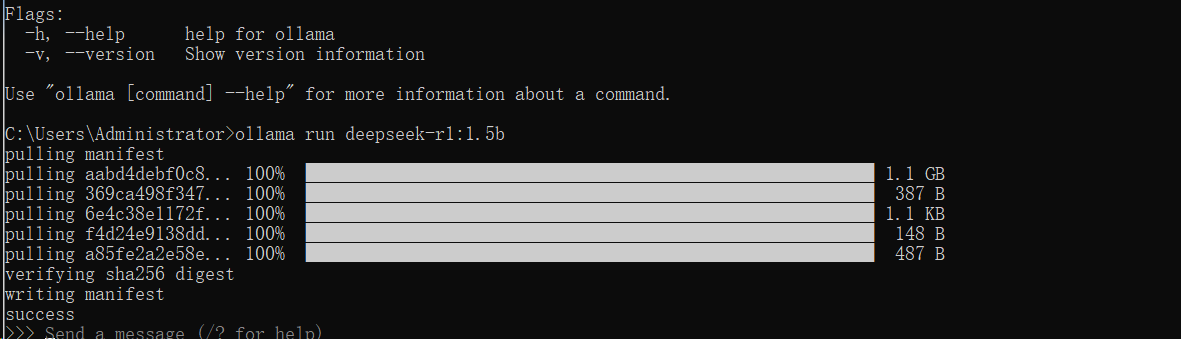

本文做测试,选择1.5b 右侧 ollama run deepseek-r1:1.5b复制下来,在本地win+R输入cmd调出cmd命令,输入ollama run deepseek-r1:1.5b 开始安装;

success以后可以进行对话,结束对话/bye即可退出,ollama run deepseek-r1:1.5b再次进入对话。

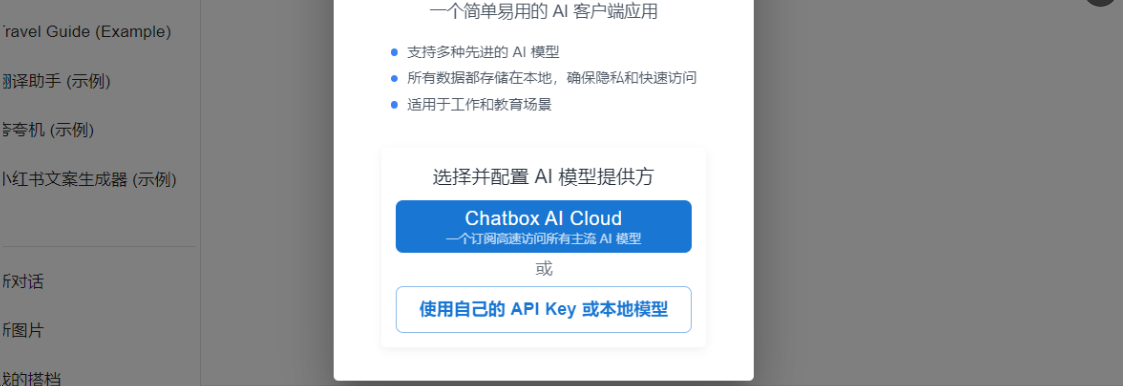

chatbox安装可视化插件

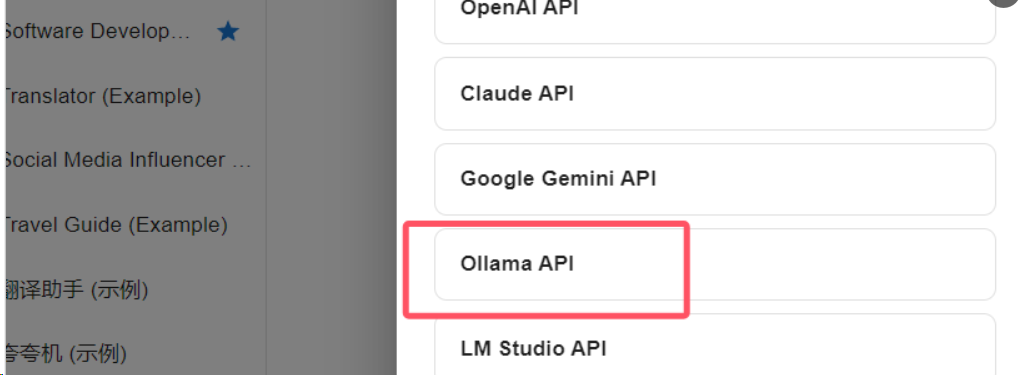

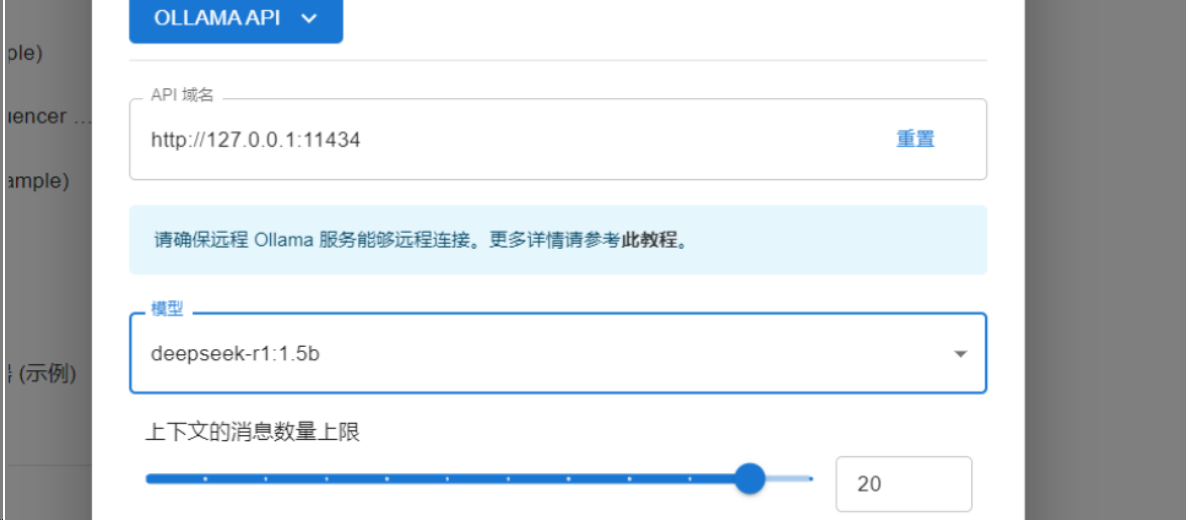

https://chatboxai.app/zh 进入官网下载免费forWindows,安装完毕打开使用自己的 API Key 或本地模型。进入模型提供方选择界面,这里选择 Ollama API,

默认情况下,Ollama 服务仅在本地运行,不对外提供服务。要使 Ollama 服务能够对外提供服务,你需要设置以下两个环境变量:

OLLAMA_HOST=0.0.0.0

OLLAMA_ORIGINS=*

在 MacOS 上配置

打开命令行终端,输入以下命令:

launchctl setenv OLLAMA_HOST “0.0.0.0”

launchctl setenv OLLAMA_ORIGINS “*”

重启 Ollama 应用,使配置生效。

在 Windows 上配置

在 Windows 上,Ollama 会继承你的用户和系统环境变量。

通过任务栏退出 Ollama。

打开设置(Windows 11)或控制面板(Windows 10),并搜索“环境变量”。

点击编辑你账户的环境变量。

为你的用户账户编辑或创建新的变量 OLLAMA_HOST,值为 0.0.0.0; 为你的用户账户编辑或创建新的变量 OLLAMA_ORIGINS,值为 *。

点击确定/应用以保存设置。

从 Windows 开始菜单启动 Ollama 应用程序。

在 Linux 上配置

如果 Ollama 作为 systemd 服务运行,应使用 systemctl 设置环境变量:

vim /etc/systemd/system/ollama.service

在 [Service] 部分下为每个环境变量添加一行 Environment:

[Service]

Environment=”OLLAMA_HOST=0.0.0.0”

Environment=”OLLAMA_ORIGINS=*”

保存并退出。

重新加载 systemd 并重启 Ollama;

systemctl daemon-reload

systemctl restart ollama

服务 IP 地址

配置后,Ollama 服务将能在当前局域网提供服务。你可以使用其他设备上的 Chatbox 客户端连接到此服务。

Ollama 服务的 IP 地址是你电脑在当前局域网的地址,通常形式如下:

192.168.X.X

在 Chatbox 中,将 API Host 设置为:

http://192.168.X.X:11434

注意事项

为避免安全风险,请不要将 Ollama 服务暴露在公共网络中。